In einer kontrollierten Umgebung wie einem Userlab ist Infrarot-Eyetracking äußerst verlässlich und liefert die genausten Daten. Da sich der Workflow von vielen jedoch in Richtung remote Arbeit entwickelt hat, ist die Nachfrage nach Usability-Tests im eigenen Zuhause sprunghaft angestiegen und viele Unternehmen verlassen sich daher auf Online-Lösungen und -Dienste.

“Wird die Drop-off-Rate berücksichtigt, liefert Webcam-Eyetracking immer noch verlässliche Ergebnisse.”

Webcam-Eyetracking klingt selbstverständlich sehr vielversprechend, da die Probanden nicht mehr persönlich anwesend sein müssen, um an Tests teilzunehmen. Die Webcam ist allerdings anfälliger für Fehler als Infrarot-Eyetracker. Gelingt es also jedem Remote-Tester, hochwertige Daten mit der eignen Webcam liefern? Die Antwort lautet leider nein. Es gibt keine Möglichkeit, im Voraus zu bestimmen, welche Benutzer Schwierigkeiten mit der Kalibrierung haben werden oder ob Probanden in ungünstigen Umgebungsbedingungen an dem Usability-Test teilnehmen. Angesichts dieser externen Faktoren ist es schwer abzuschätzen, wie viele Testnutzer rekrutiert werden müssen, um die gewünschten Datensätze zu erhalten.

Das bedeutet jedoch nicht, dass Eyetracking mit Webcam keine geeignete Lösung ist. Wird die Drop-off-Rate berücksichtigt, liefert Webcam-Eyetracking immer noch verlässliche Ergebnisse. Über die Anzahl der benötigten Testpersonen haben wir hier unsere Ergebnisse veröffentlicht: Webcam Eye Tracking: Study Conduction and Acceptance of Remote Tests with Gaze Analysis

“Um zu belegen, dass die Webcam-Eyetracking-Daten nicht zufällig, sondern akkurat waren, haben wir überprüft, ob der bekannte gaze cueing effect auf den Screenshots erkannt werden konnte.”

57 remote Tester meldeten sich online an, um an einer kurzen Webcam-Eyetracking-Studie teilzunehmen. Sie erhielten per E-Mail einen Teilnahme-Link sowie hilfreiche Tipps, wie z. B. den Kopf möglichst still zu halten. Nachdem die Probanden auf den Link klickten, öffnete sich die EYEVIDO Lab-Testeroberfläche im Browser und begann mit der Kalibrierung der Webcam. Die Teilnehmer wurden aufgefordert, sich die scrollbaren Screenshots intuitiv anzusehen, genauso wie sie es normalerweise machen würden.

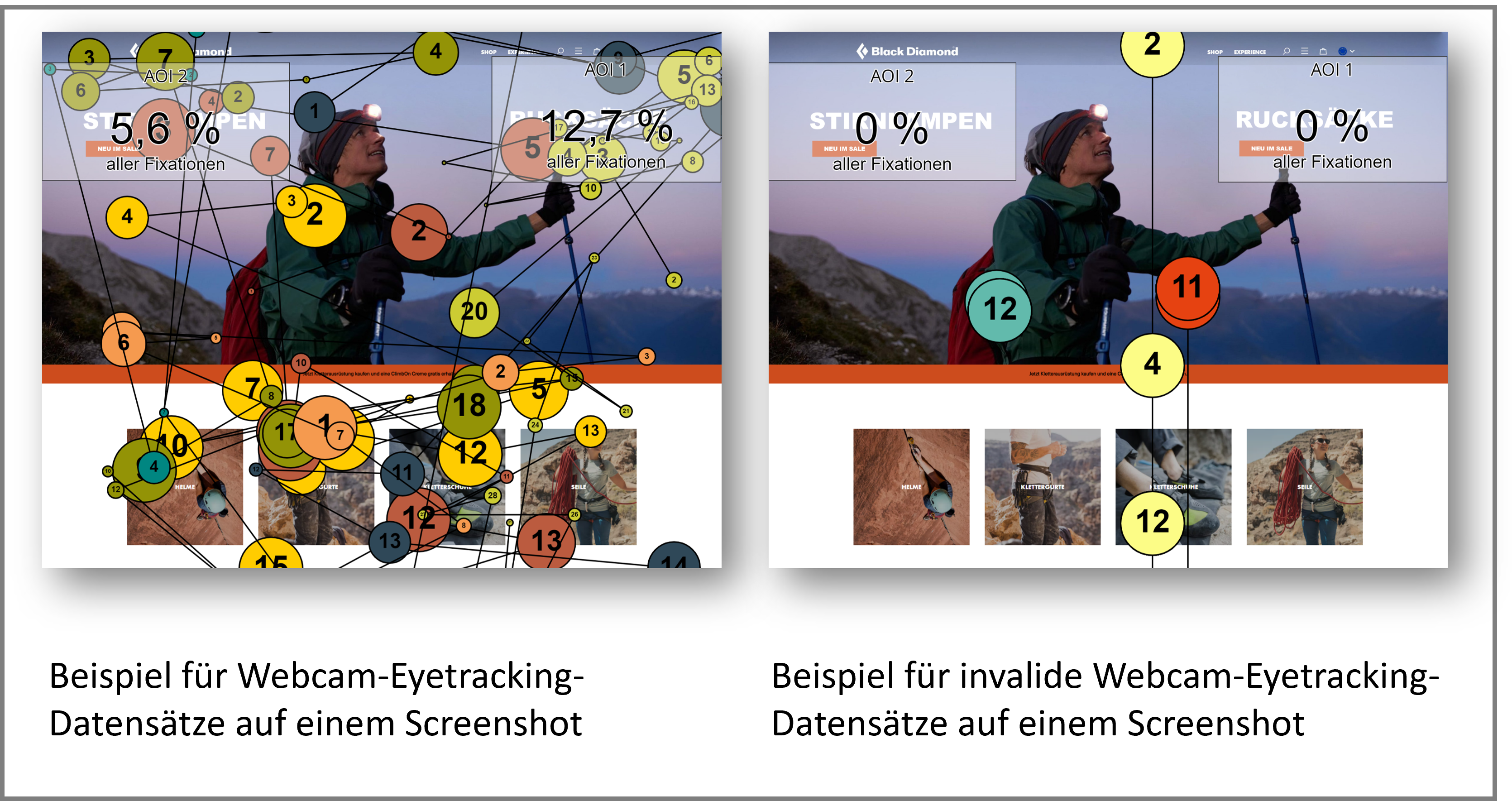

Um zu belegen, dass die Webcam-Eyetracking-Daten nicht zufällig, sondern akkurat waren, haben wir überprüft, ob der bekannte gaze cueing effect* auf den Screenshots erkannt werden konnte.

*Betrachtet man einen Pfeil oder den Blick einer anderen Person, so richtet sich unsere Aufmerksamkeit in dieselbe Richtung.

“Insgesamt kann Webcam-Eye-Tracking genaue Daten liefern, aber eine hohe Drop-off-Rate muss berücksichtigt und durch eine Überrekrutierung von etwa + 150 % ausgeglichen werden.”

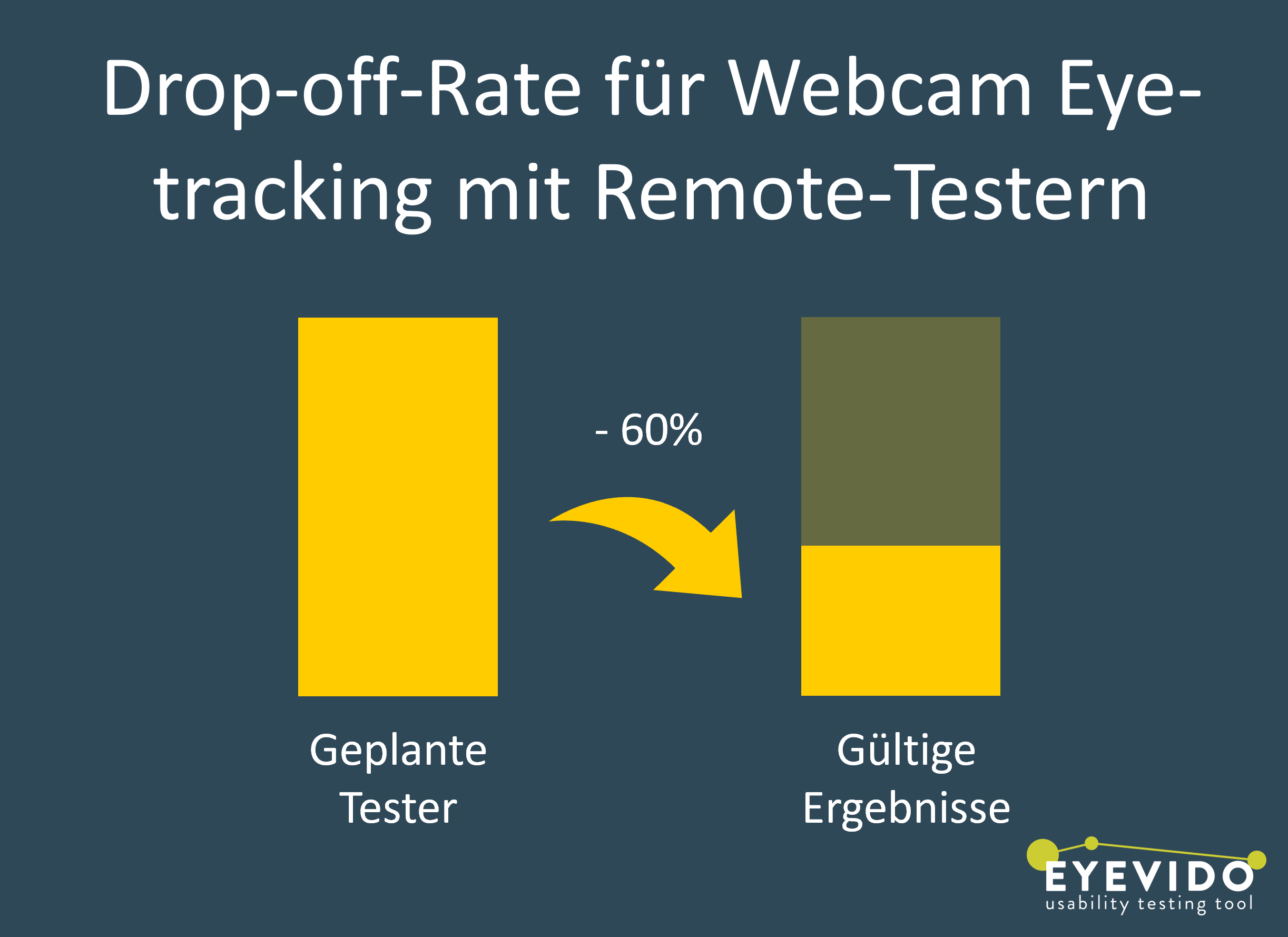

Etwa 40 % der Testpersonen hatten gültige Ergebnisse. In unserer Evaluierung mit EYEVIDO Lab konnten wir Verhaltensmuster visualisieren und die am stärksten fokussierten Bereiche mit Heatmaps und AOIs korrekt identifizieren. Äußere Einflüsse auf Seiten der Teilnehmer führten bei einigen zu einer ungültigen Datenaufzeichnung, während andere nicht über die Kalibrierung hinauskamen. Diese beiden Probleme waren die Hauptursachen für die Drop-off-Rate von etwa 60 %.

Insgesamt kann Webcam-Eye-Tracking genaue Daten liefern, aber eine hohe Drop-off-Rate muss berücksichtigt und durch eine Überrekrutierung von etwa + 150 % ausgeglichen werden.

Wir haben alle unsere Erkenntnisse zu diesem Thema hier öffentlich zugänglich gemacht: Webcam Eye Tracking: Study Conduction and Acceptance of Remote Tests with Gaze Analysis